„Bei Gefahr muss die Warnlampe aufleuchten“

Es wird gepöbelt, gehetzt, gelogen und immer öfter auch zu Gewalt aufgerufen – gegen Minderheiten, Andersdenkende oder Politiker*innen. Hass in den sozialen Netzwerken ist längst ein Massenphänomen geworden, das die Debattenkultur und Demokratie gefährdet und häufig ernste strafrechtliche Relevanz hat. Wie lassen sich mögliche Straftatbestände in Hasskommentaren und Fake News erkennen, herausfiltern und ihre Ahndung beschleunigen? Damit befasst sich das Forschungsprojekt „BoTox“ der h_da-Computerlinguistin Melanie Siegel. Es wird über die Forschungsförderung Cybersicherheit des Hessischen Ministeriums des Innern, für Sicherheit und Heimatschutz gefördert.

Von Astrid Ludwig, 28.2.2024

Sozialschmarotzer, Volksverräter, Scheißjuden - Wortwahl und Stimmung werden immer aggressiver. Rassistische, menschenverachtende und sexistische Beschimpfungen, Shit-Stürme oder auch Bedrohungen sind trauriger Alltag in den sozialen Medien. „Wenn aber Sätze auftauchen wie: Ich habe mir eine Waffe gekauft, dann muss die rote Warnlampe aufleuchten“, sagt Melanie Siegel. „Das bedeutet eine mögliche konkrete Gefahr, die strafrechtlich erkannt und automatisch an die richtigen Stellen weitergemeldet werden muss.“ Genau daran arbeiten die Computerlinguistin und ihr Forschungsteam aktuell.

Die Professorin für semantische Technologien befasst sich seit 2017 mit Hass und Lügen im Netz und war eine der ersten Wissenschaftlerinnen, die dieses Phänomen im deutschsprachigen Raum intensiv untersucht haben. Die „offensive Sprache im Internet“, so der Fachterminus, ist einer ihrer Forschungsschwerpunkte. Hetze und Bedrohungen müssen nicht hingenommen werden. „Dagegen lässt sich etwas tun“, betont sie.

„Detektion von Toxizität und Aggression in Postings und Kommentaren im Netz“ – kurz DeTox – hieß eines ihrer ersten Forschungsprojekte, in dem es darum ging, anwendbare Textanalysen und Filter für Hate Speech mit Hilfe Künstlicher Intelligenz zu entwickeln. Schon damals arbeitete sie mit dem hessischen Innenministerium zusammen, das 2020 die Meldestelle „HessenGegenHetze“ einrichtete. Dorthin können sich Bürger*innen wenden, wenn sie selbst Opfer sind oder Hasskommentare melden wollen.

Innovative Lösungen

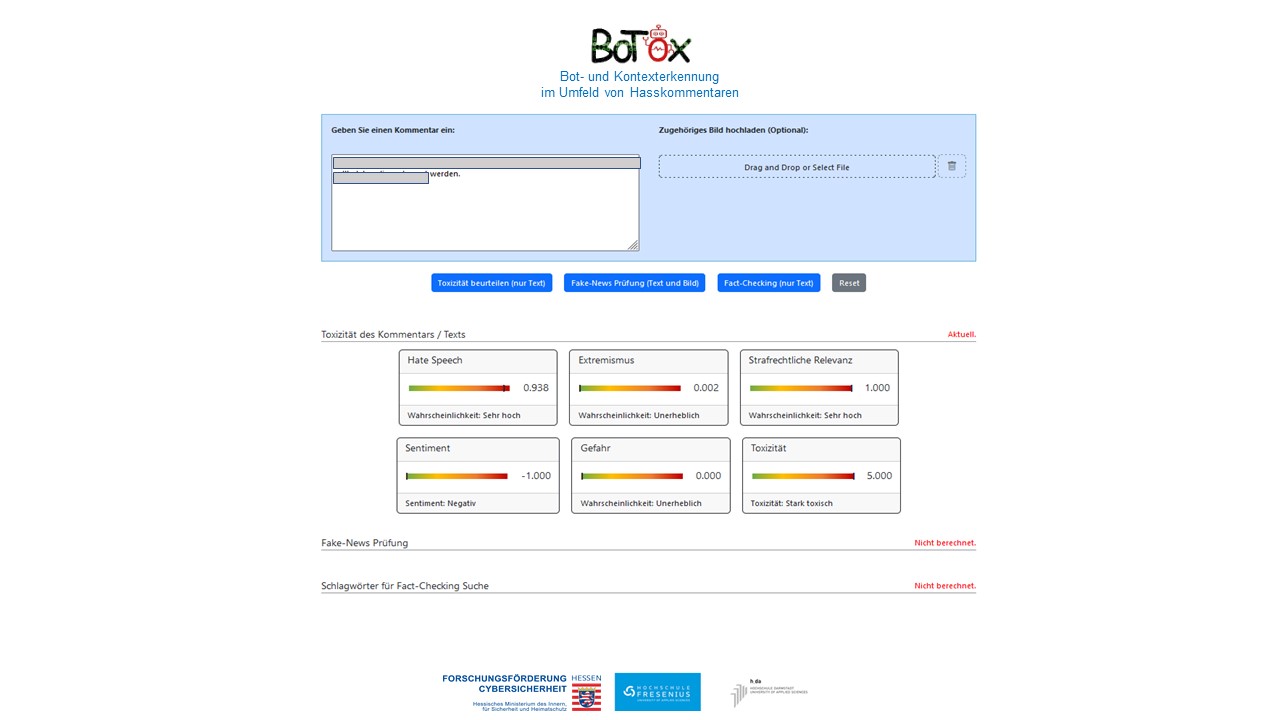

Seit Januar 2021 fördert das Innenministerium in Wiesbaden Projekte zur Cybersicherheit, die dazu beitragen, „innovative Lösungen zu entwickeln, die auch dem Schutz unserer digitalen Infrastrukturen und unserer Sicherheit praktisch dienen können“, erklärt Innenstaatssekretär Stefan Sauer. Das h_da-Forschungsprojekt „BoTox – Bot- und Kontexterkennung im Umfeld von Hasskommentaren“ ist eines davon. Bis 2025 stehen Professorin Siegel und ihrem Team dafür 292.000 Euro zur Verfügung. „Unser Fokus“, sagt sie, „liegt auf der Erkennung der strafrechtlichen Relevanz von Hasskommentaren.“

Die Forschenden, zu denen auch ein wissenschaftlicher Mitarbeiter sowie vier studentische Hilfskräfte zählen, wollen ein System entwickeln, das automatisch erkennt, wann Textbeiträge und Kommunikationsverläufe mögliche Aspekte wie etwa Beleidigung, Volksverhetzung oder auch den Aufruf zur Gewalt erfüllen. „Wir haben zwölf unterschiedliche Straftatbestände herausgearbeitet“, so die Professorin. Die neue Anwendung soll mit Hilfe automatischen Lernens und künstlicher Intelligenz diese Inhalte nicht nur erkennen, auswerten und vorklassifizieren, sondern sie auch gleich an die Meldestelle „HessenGegenHetze“ weiterleiten. Ziel ist, die Arbeit der Meldestelle zu unterstützen, zu erleichtern und effizienter zu machen. „Damit bei einer Bedrohung schneller agiert werden kann“, sagt die Computerlinguistin. Dafür braucht das Forschungsteam natürlich juristische Kenntnisse und Grundlagen. Die steuert Prof. Dirk Labudde von der Hochschule Fresenius in Idstein bei, mit dem Melanie Siegel schon bei früheren Projekten zusammengearbeitet hat. Labudde ist juristischer Gutachter und Professor für digitale Forensik.

Bot oder Mensch?

Erforschen will das h_da-Team weitere Aspekte. Relevant ist nämlich auch, ob der Hasskommentar von einem Bot, also einem Computerprogramm, oder einem Menschen verfasst wurde. In Zeiten von KI-Anwendungen wie ChatGPT gar nicht so leicht herauszufinden, sagt Siegel. Texte automatisch zu generieren ist wesentlich einfacher geworden. „Wir haben es selbst ausprobiert und von ChatGPT Hasskommentare schreiben lassen.“ Zwar haben die Entwickler*innen von OpenAI ethische Leitplanken in ihre Software eingebaut, aber die lassen sich umgehen, „wenn man die richtigen Fragen und Aufgaben stellt“, so die Professorin. „Auch das ist eine wichtige Erkenntnis für uns.“

Anschauen will sich das Team auch den Kontext, in dem Hass und Hetze auftauchen. Wie verbreitet ist Hassrede insgesamt im Netz und was passiert, wenn User*innen dagegenhalten? Wird es dann besser oder schlimmer? Ist es sinnvoller, die Trolle nicht zu „füttern“ oder sollte man bewusst toxische Aussagen kritisieren? „Was kann man gegen Hasskommentare tun“, beschreibt die h_da-Expertin den Ansatz.

Um die Software auf die automatische Erkennung von Hassrede und all diese Aspekte zu trainieren, ist eine große Datenmenge nötig. Wichtig: Damit das System überhaupt lernt zu unterscheiden, brauchen die Forschenden eine ausreichend große Anzahl zutreffender Beispiele von Hasskommentaren, aber auch eine Vielzahl unzutreffender Aussagen. Die Daten sollen zudem die Realität abbilden. Hatespeech, sagt die Professorin, wird deutlich häufiger von Männern als von Frauen gepostet. Ultrarechte Gruppierungen sind dabei aktiver als ultralinke, so die Erkenntnis. Auch das müssen die Datensätze widerspiegeln. Wichtig ist ebenso die Bewertungsgrundlage. Drei ihrer studentischen Hilfskräfte lesen dieselben Kommentare und bewerten diese dann. Ist es eine extreme Meinung, beleidigend oder schon volksverhetzend? Fallen die Bewertungen ähnlich aus? „Eine Sisyphos-Arbeit“, sagt Siegel.

Twitter existiert nicht mehr als Datenquelle

Für frühere Forschungsprojekte konnten Siegel und ihr Team auf den Messenger-Dienst Twitter zurückgreifen. Für das DeTox-Projekt etwa haben sie dank einer Forschungslizenz rund eine Million Twitter-Daten aus Kommentaren zu politischen Fernsehtalks sammeln können. Heute jedoch ist Twitter oder vielmehr X nicht mehr zugänglich, „weil Forschungslizenzen so teuer wurden, dass sie sich keiner mehr leisten kann“, berichtet sie. Daher muss das Team jetzt auf andere Plattformen wie Facebook, Telegram oder YouTube zurückgreifen, „und auch da ist der Zugang nicht einfach“. Hilfreich sind jedoch die Daten der Meldestelle „HessenGegenHetze“, die mittlerweile bekannter ist. Meldeten User*innen anfänglich rund 2000 Kommentare pro Monat, ist es heute die gleiche Anzahl pro Woche.

Die bereits vorhandenen Trainingsdaten nutzt das Team jedoch auch weiterhin. Zwar sind nicht alle Themen abgebildet – Covid-19 war noch unbekannt und auch der Krieg in der Ukraine nicht ausgebrochen – „aber wir arbeiten daran, die Daten übertragbar zu machen“, erklärt die Forscherin. Bei manchen ist das leicht: „Zu Kanzlerin Merkel etwa gab es eine ähnliche Wortwahl wie heute zur Ampel.“ Viele Themen sind auch geblieben. Meist geht es um Antisemitismus, Holocaust-Leugnung, Ausländerfeindlichkeit, Migration, Rassismus oder Diskriminierung von Minderheiten.

Einfließen sollen zudem neue wissenschaftliche Erkenntnisse. So hat die h_da-Doktorandin Mina Schütz die Wortwahl bei Fake News erforscht und herausgefunden, dass bei Lügen im Netz eine sehr viel emotionalere Sprache verwendet wird als in wissenschaftlichen oder journalistischen Texten. Auch werden Personalpronomen häufiger benutzt, ebenso Ausrufezeichen, Emojis und große Überschriften. Der Doktorand Jian Xi hat das Zusammenspiel von Bild und Text bei Fake News untersucht. Siegel ist es wichtig, ihre Studierenden einzubinden und die Forschungsergebnisse aktuell in die Lehre einfließen zu lassen. Aufklärungsarbeit will sie aber auch als Referentin leisten. Demnächst hält sie Schulungen und Workshops an einer Polizeiakademie: „Dort sitzen Polizist*innen und Jurist*innen, die sich auskennen müssen.“

Kontakt zur h_da-Wissenschaftsredaktion

Christina Janssen

Wissenschaftsredakteurin

Hochschulkommunikation

Tel.: +49.6151.533-60112

E-Mail: christina.janssen@h-da.de

Weiterführende Links